无

”spark安装 python测试“ 的搜索结果

1、linux:centos 6.8,安装过程参见http://www.cnblogs.com/zhwyxuhui/p/8983663.html2、java版本:jdk-8u172-linux-x64.tar.gz3、hadoop版本:hadoop-3.1.0.tar.gz4、scala版本:scala-2.12.6.tgz5、python版本:...

安装好Spark 后,自带了一些demo, 路径在Spark根目录/examples/src/main/python/里面有些例子,例如统计字数的 wordcount.pyimport sysfrom operator import addfrom pyspark import SparkContextimport sysreload...

安装lib材料:spark:http://spark.apache.org/downloads.htmlhadoop:http://hadoop.apache.org/releases.htmljdk:http://www.oracle.com/technetwork/java/javase/downloads/index-jsp-138363.htmlhadoop-commin:h...

首先,Spark python开发环境搭建的准备工作:Win10 64位专业版Anaconda3Java 8 64位Spark基于Hadoop 2.7 64位下载和准备介质:安装与配置Anacondahttps://www.anaconda.com/products/individual安装与配置Java...

spark 使用python操作(基于pycharm的安装使用)

有时候我们会在windows 下开发spark程序,测试程序运行... 我的windows环境为 Win7 64位第一步,安装Python环境这里不多讲,我的环境为python 3.6第二步,安装Java 环境我的环境为C:\Users\Boss>java -versionjava v...

spark-python版本依赖与三方模块方案本文讲解spark client模式和cluster模式的第三方库依赖解决方法,注意,在用的时候需要看清楚自己的集群是哪种方法部署spark。更新:2019-12-181、cluster模式如果spark集群是以...

下载必要的组建组建地址安装这里的scala是对需要使用scala的语言的人准备... 解压spark (D:\spark-2.0.0-bin-hadoop2.7)c. 解压hadoop (D:\hadoop2.7)d. 解压hadoop-commin (for w7)e. copy hadoop-commin/bin to ha...

使用云服务器搭建hadoop集群,hadoop、yarn和spark配置文件设置,spark on yarn 环境搭建,python任务提交测试,spark-submit提交python任务测试,及其spark-submit提交参数详解

spark-python版本依赖与三方模块方案 本文讲解spark client模式和cluster模式的第三方库依赖解决方法,注意,在用的时候需要看...(1)使用conda创建python虚拟环境、安装第三方库 假设虚拟环境是pyspark_py36,安...

spark能跑Python么?spark是可以跑Python程序的。python编写好的算法,或者扩展库的,比如sklearn都可以在spark上跑。直接使用spark的mllib也是可以的,大部分算法都有。Spark 是一个通用引擎,可用它来完成各种各样...

摘要:pandas是一个强大的Python数据分析工具包,...在Spark中,python程序可以方便修改,省去java和scala等的打包环节,如果需要导出文件,可以将数据转为pandas再保存到csv,excel等。1.Pandas是什么?pandas是一...

spark编程python实例ValueError: Cannot run multiple SparkContexts at once; existing SparkContext(app=PySparkShell, master=local[])1.pyspark在jupyter notebook中开发,测试,提交1.1.启动IPYTHON_OPTS=...

准备工作查看操作系统的版本...1安装Anaconda1.1 下载注意选择与操作系统匹配的版本,截止写本教程时,官方版本为Anaconda5.0.1,内部封装的为Python3.6,也可根据需要下载封装其他版本Python的Anaconda3下载地址为:...

原标题:Windows和PC机上搭建Spark+Python开发环境的详细步骤 引 言自本人的Spark+R编程系列教程发布以来,很多读者来信询问Spark+Python开发环境的搭建方法,并希望由我一篇如何在个人PC和Windows上搭建Spark+...

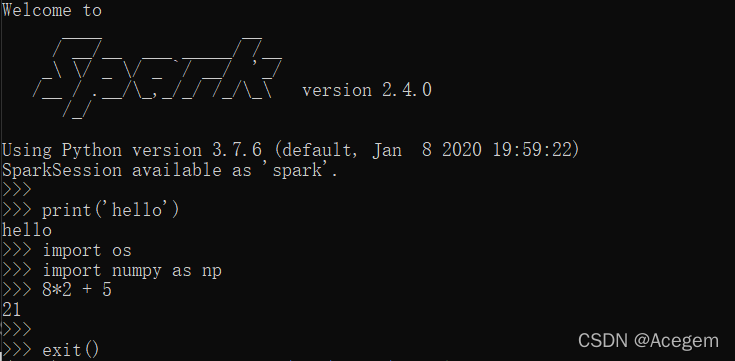

概述Spark提供了两种交互式shell, 一个是pyspark(基于Python), 一个是spark_shell(基于Scala). 这两个环境相互独立并无依赖关系, 所以如果仅仅是使用pyspark交互环境, 是可以不安装scala的。常见的几种spark部署模式...

Spark作为一种通用且高性能的计算框架,不仅在性能上相对于hadoop mapreduce有了很...Spark目前提供了Standalone/Yarn/Mesos几种安装模式,其中Standalone模式最为方便快捷。在这种模式下,Spark使用自由资源管理框...

Big Data with Apache Spark and Python 英文无水印pdf pdf所有页面使用FoxitReader和PDF-XChangeViewer测试都可以打开 本资源转载自网络,如有侵权,请联系上传者或csdn删除 本资源转载自网络,如有侵权,请...

通过VMware创建新Ubuntu Linux环境,安装配置伪分布式Hadoop集群,Spark, VMwaretools,及多版本Python与版本选择。

Spark、Python spark、Hadoop简介 Spark简介 1、Spark简介及功能模块 Spark是一个弹性的分布式运算框架,作为一个用途广泛的大数据运算平台,Spark允许用户将数据加载到cluster集群的内存中储存,并多次重复...

1、资源内容:机器学习作业-基于spark+python的推荐系统的实现(电影推荐系统)+源代码+文档说明+数据 2、代码特点:内含运行结果,不会运行可私信,参数化编程、参数可方便更改、代码编程思路清晰、注释明细,都...

spark能跑Python么?spark是可以跑Python程序的。python编写好的算法,或者扩展库的,比如sklearn都可以在spark上跑。直接使用spark的mllib也是可以的,大部分算法都有。Spark 是一个通用引擎,可用它来完成各种各样...

1、集群测试实例代码如下:from pyspark.sql import SparkSessionif __name__ == "__main__":spark = SparkSession\.builder\.appName("PythonWordCount")\.master("spark://mini1:7077") \.getOrCreate()spark.conf...

由于目前很多spark程序资料都是用scala语言写的,但是现在需要用python来实现,于是在网上找了scala写的例子改为python实现1、集群测试实例代码如下:from pyspark.sql import SparkSessionif __name__ == "__main__...

推荐文章

- c语言链表查找成绩不及格,【查找链表面试题】面试问题:C语言学生成绩… - 看准网...-程序员宅基地

- 计算机网络:20 网络应用需求_应用对网络需求-程序员宅基地

- BEVFusion论文解读-程序员宅基地

- multisim怎么设置晶体管rbe_山东大学 模电实验 实验一:单极放大器 - 图文 --程序员宅基地

- 华为OD机试真题-灰度图恢复-2023年OD统一考试(C卷)-程序员宅基地

- 【机器学习】(周志华--西瓜书) 真正例率(TPR)、假正例率(FPR)与查准率(P)、查全率(R)_真正例率和假正例率,查准率,查全率,概念,区别,联系-程序员宅基地

- Python Django 版本对应表以及Mysql对应版本_django版本和mysql对应关系-程序员宅基地

- Maven的pom.xml文件结构之基本配置packaging和多模块聚合结构_pom <packaging>-程序员宅基地

- Composer 原理(二) -- 小丑_composer repositories-程序员宅基地

- W5500+F4官网TCPClient代码出现IP读取有问题,乱码问题_w5500 ping 网络助手 乱码 send(sock_tcps,tcp_server_buff,-程序员宅基地